멘토링

RL for recSys with Ray RLlib

강화학습을 추천시스템에 사용하는 법

Ray 프레임워크

RLlib 라이브러리

튜토리얼 링크 : https://github.com/anyscale/academy

applicaiton of Reinforcement learning

-observation

-action

-Rewards

환경에서 액션에 따른 새로운 상태와 새로운 리워드를 받게되며, 이는 새로운 observation이 된다.

목표 : '누적' 보상액을 최대화 하는 것

정책 : 에이전트가 행동을 선택하는데 사용하는 규칙

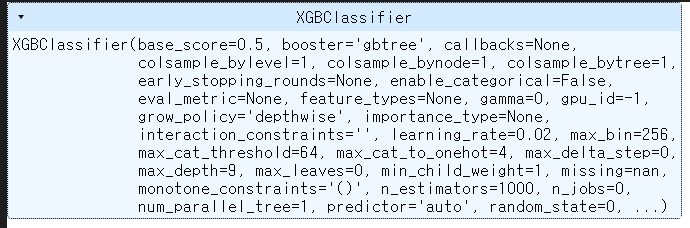

XGBoost

int, float, bool or category 변수를 받는다. str 타입을 인풋으로 받지 않는다.

일단 catboost와의 차이점이 두드러진다.

모델을 돌렸을 시 category 변수보다는 중복도가 낮았던 변수가 feature importance가 높게 측정이 되었다.

즉, catboost와 달리 요구하는 feature의 특징이 다르다는 점.

이는 FE에서 새로운 접근 방식으로 시도해봐야 할 것 같다.

Cardinality

중복도가 낮으면 cardinality가 높다.

중복도가 높으면 cardinality가 낮다.

즉, catboost는 cardinality가 낮을 때 성능이 좋다.

XGboost에서는 cardinality가 높은 feature의 importance가 높게 측정이 되었다.

+) 이거 외에 ai ground에서 데이터 셋을 참고해서 여러 디폴트 세팅을 하고 있는데 쉽지가 않다.

접근 방법을 다시 항번 생각해 봐야 할 수도 있을 것 같다.

오늘의 회고

DKT 6일차의 날이 밝았다.

오늘은 데이터 파일 정리랑 xg boost 를 기초적으로 만들어보고 성능을 확인해 보았다.

그 후 주피터 노트북으로 만들어진 결과를 .py 파일로 만들면서 모듈화를 할 수 있는 방법을 시도해보고 있다.

하지만 아직까지 만족스럽게 완성이 되지는 않아서 아쉬움으로 남고 있다.

ai ground 는 아직까지 활로가 마땅히 찾지 못해서 계속 데이터와 도메인 지식들을 보면서 어떤 추천 방식으로 해야 좋을지를 생각해 보고 있다. 계속해서 머리 속에 떠오른 아이디어를 구현해봐서 확인 할 필요가 있다.

'부스트캠프 4기 RecSys' 카테고리의 다른 글

| [부스트캠프] dkt 11,12일차 (0) | 2022.11.29 |

|---|---|

| [부스트캠프] DKT 7,8일차, AI ground (0) | 2022.11.23 |

| [부스트캠프] 9주차 회고 , DKT 5일차 (2) | 2022.11.18 |

| [부스트캠프] DKT 4일차 (3) | 2022.11.18 |

| [부스트캠프] DKT 3일차 (2) | 2022.11.17 |